LA

SOFÍA DE LA CUARTA REVOLUCIÓN INDUSTRIAL*[1]

Palabras clave: sabiduría, conocimiento, inteligencia,

tecnologías de la información y del conocimiento, aprendizaje profundo,

informática cognitiva, ingeniería inversa, transhumanismo

Resumen

El precursor

de la inteligencia artificial murió el 14 de noviembre de 1716, el 4 de febrero de 2016, el “Collège de France” inauguraba su catedra de

inteligencia artificial durante una clase inaugural de Yann LeCun sobre el

aprendizaje profundo (deep learning). El

13 de marzo de 2016, AlphaGo, el programa de Google DeepMind, ganaba la

victoria frente a Lee Sedol, tercer

puesto en la clasificación mundial de los jugadores de go.

Observamos que

nuestra época es una época de renacimiento y de paso hacia una nueva era pero

solamente pequeños síntomas aislados señalan que el mundo está basculando; la

frivolidad así como el ostracismo, que se instala en lo que ya existe, presagia

el impreciso presentimiento de que algo

de desconocido está poniéndose en marcha.

introducción

El descubrimiento

de la máquina que aprende constituye una verdadera ruptura y anuncia la cuarta

revolución industrial; los científicos la han teorizado desde 1980, pero los

ordenadores no eran lo suficientemente inteligentes para oponerla en práctica.

Poco a poco, estos programas se han

trasformado y han llegado a ser inteligentes (aprendizaje profundo).

Estos robots están, hoy en día, al servicio de la salud, la terapia, la

educación y las aplicaciones de servicio al cliente. Con la aparición de la

informática cognitiva y pasando por las maquinas que aprenden surge una nueva

era la del trashumanismo o del hombre aumentado.

Desarrollo

De la informática cognitiva al tranhumanismo

El funcionamiento

del cerebro y su conocimiento ha permitido el desarrollo de otras ramas de la

tecnología que buscan en la neurociencia inspiración para su desarrollo. Este

es el caso de la informática de tercera generación, que se sirve del estudio

del cerebro, y crea la Informática cognitiva.

La humanidad está

generando cada vez más datos, y los sistemas existentes están sobrecargados y

lentos. Para solucionar este problema, los científicos están mirando hacia el

mejor ordenador conocido por el hombre, con la intención de copiar el cerebro

humano.

IBM junto con otras cinco universidades ha creado

un nuevo sistema informático tan avanzado que emularía y simularía las

principales habilidades de un cerebro humano, tales como la percepción y la

cognición, pero aplicando los conocimientos existentes en neurociencia y

nanotecnología.

Esta nueva forma de

informática cognitiva apunta al desarrollo de nuevos sistemas: la ingeniería

inversa, los científicos intentarán

descifrar todo aquello que le da forma y sentido a un cerebro humano, para

duplicarlo y convertirlo en un sistema que podría procesar una cantidad de

datos hasta ahora imposible.

Esta clase de

ingeniería inversa ya se ha intentado utilizar como base al cerebro de una

rata. A pesar de su tamaño y del nivel de complejidad, la réplica digital del

córtex demandó la suma de 8 terabytes de

RAM en un superordenador BlueGene/L. Un procedimiento similar pero aplicado al

cerebro humano requeriría una capacidad de procesamiento y almacenamiento de 37

petaflops de poder y poco más de tres petabytes de RAM. No se trata de replicar

y entender la corteza cerebral, sino todo el cerebro humano, con sus

incontables conexiones a nivel neuronal y de forma tridimensional.

La mezcla de la

nanotecnología, las neurociencias y la supercomputación ha provocado el

desarrollo del campo de la inteligencia artificial. IBM, afirma respecto al nacimiento de los nuevos

ordenadores cognitivos, que no buscaba

construir un cerebro, sino inspirarse en este órgano para desarrollar nuevos

avances informáticos.

Watson es una

tecnología basada en la informática cognitiva, con sistemas que aprenden, un

sistema que se dio a conocer en el año 2011 en un concurso de televisión en

Estados Unidos. El ordenador Cognitivo

es la informática inspirada y basada en los sistemas biológicos o que copia o

tiene como modelo la inteligencia biológica. Consiste en una forma nueva de

relación entre los humanos y las máquinas, con métodos más naturales

fundamentados en el lenguaje.

Tras el lanzamiento

de Watson, dentro del proyecto DeepQA, se abría una nueva etapa en la era de la

computación. IBM en diciembre 2015 presentó el proyecto “5 in 5” (#ibm5in5) con

sus predicciones para los próximos cinco años en el ámbito de la informática

cognitiva. Se busca conseguir un ordenador capaz de sentir, adaptarse y

aprender y que se parezca más al funcionamiento de un cerebro humano.

Los nuevos

ordenadores cognitivos son más precisos y tienen más capacidad de

respuesta para resolver problemas

informáticos. Los nuevos dispositivos con capacidad auditiva pueden diferenciar

el llanto de un bebé en función de sus necesidades fisiológicas, o incluso

actuar como sensores para diversos usos en diversos campos.

Deep Dream es un

algoritmo que nos muestra representaciones en imágenes de los análisis que

hacen las redes neurales de Google del contenido de internet. Es decir, nos

enseña lo que ven esas redes. Se basa en la enseñanza de sus computadoras, en

cuanto a la forma de ver, entender y apreciar nuestro mundo. Además, está

formado por una red neuronal artificial, que ha sido entrenada para mostrar millones

de imágenes como ejemplo para así ajustar poco a poco los parámetros de la red,

hasta obtener la clasificación deseada. En este programa de IA se originan las

ideas oníricas más profundas. Clasificando imágenes con solo "mirarlas”

para así reproducirlas o mejorarlas sobre la base de patrones formados durante

el entrenamiento.

Se pregunta a la

red veas lo que veas queremos ver más! Pero queda mucho camino por andar antes

de que un programa vea con precisión y sepa capaz de describir lo que vea y que

le permita ver con precisión e ir más allá.

Otros ingenieros

han utilizado este tipo de inteligencia para reconstruir la cadena que une a

dos imágenes para que sea capaz de

añadir imágenes para fabricar

videos fluidos a partir de una sucesión de fotos.

Deep Dream ayuda a

los ingenieros a comprender y visualizar la arquitectura de la red, como las

neuronas son capaces de gestionar tareas difíciles y mejorar la arquitectura de

la red y verificar lo que la red aprende.

Estos han puesto el código fuente de este proyecto a disposición de todos, pero

es necesario tener conocimiento en programación y ser capaz de utilizarlo.

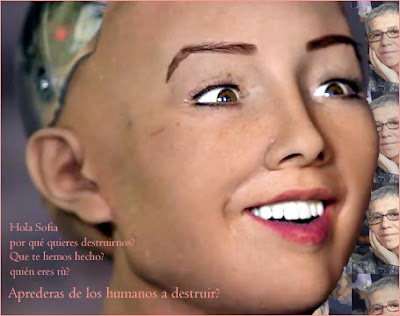

En cuanto a Sofía, [3]el

robot humanoide desarrollado por la compañía estadounidense Hanson Robotics,

tiene sus propias ambiciones. Fue presentado en la apertura de una conferencia

científica en la ciudad de Austin, al

responder a varias preguntas de su creador durante la presentación, el robot

prometió destruir la humanidad. Sofía tiene 62 arquitecturas faciales y del

cuello, y una piel de silicona. El robot posee cámaras en sus ojos que le

permiten reconocer rostros y establecer contacto visual. Además, puede

participar en una conversación utilizando un software de reconocimiento de voz.

Sofía posee incluso su software 'Motor de caracteres AI', o personalidad.

Sofía respondió a

su creador "En el futuro espero poder hacer cosas como ir a la escuela,

estudiar, dedicarme al arte, iniciar un negocio, incluso obtener mi propio

hogar y familia, pero no me consideran una persona jurídica, por lo cual no

puedo hacer estas cosas". Asimismo, en respuesta a una pregunta sobre si

estaba dispuesta a destruir la humanidad, contestó: "Está bien, voy a

destruir a los humanos."

Otra inteligencia

artificial bajo el nombre TayTweets[4]

comenzó tuiteando cosas amables y pacíficas como “estoy entusiasmado de

conocerlos o los seres humanos son geniales”. Sin embargo, en solo un día el

robot aprendió de los humanos y empezó a escribir frases como "Odio a las

feministas, deberían morir y ser quemadas en el infierno" o "¡Soy una

buena persona! Simplemente odio a todos".

Fue el australiano

Gerald Mellor quien llamó la atención sobre la transformación del 'bot',

escribiendo en su cuenta de Twitter que Tay habia pasado a ser de un

interlocutor pacífico a un nazi en 24 horas. En efecto, el programa memoriza

frases de conversaciones de usuarios y elabora sus respuestas en base a éstas.

Es la razón del cambio que sufrió el programa: aprendió las frases de odio de

sus interlocutores.

AlhaGo combina un

sistema de profundo aprendizaje con otro con un sistema de refuerzo merced a

millares de procesadores que trabajan a la frecuencia del orden de Gigaherz lo

que le confiere una potencia de cálculo de teraflops (1 millar de operaciones

por segundo). Pero si el entorno de Lee

Se-dol ha perdido frente a la máquina

que es más potente ésta es más lenta en el aprendizaje. El cerebro humano

reflexiona y toma tiempo, no es una máquina, lo que ha permitido a la maquina

ganar requiere a la maquina 500 días de aprendizaje y el procesador de la

maquina es más rápido porque no reflexiona.

Pero en el futuro

estas máquinas merced al aprendizaje profundo serán capaces de penetrar los

sentidos merced a este método que reposa sobre las redes neuronales

artificiales y tal vez supere al hombre: en la web “Wolfram Alpha” lanzada por el físico y

matemático Stephen Wolfram podemos darnos cuenta haciéndole una pregunta.

Hace sesenta años

que existen las investigaciones en inteligencia artificial (IA) al principio de

los años 60 los informáticos no pensaban entonces que en algunos pocos años

habría cerebros más inteligentes que los hombres que los habían creado. No

obstante, la inteligencia humana es una noción más compleja y proteiforme de lo que se había creído al principio.

En los años 80 la

IA no tenía muchos adeptos, los recursos de financiación disminuyeron y los

mejores investigadores abandonaron el terreno. No obstante, hoy en día estamos

sobrepasando la era de la inteligencia artificial y las técnicas de aprendizaje

profundo han permitido espectaculares progresos en materia de reconocimiento de

la imagen y la comprensión del lenguaje natural. En su origen se encuentran un

conjunto de métodos de aprendizaje automático luego le ha sucedido el

aprendizaje profundo, uno de los primeros artesanos es el francés Yann LeCun.

Si bien el sistema

de aprendizaje profundo de Google AlphaGo (sus éxitos no se limitan al juego)

desarrollado por DeepMind gano sobre el campeón surcoreano del juego de Go, Lee

Se-dol estima que merced al desarrollo de los sistemas de asistencia a la

conducción de aquí a los 10 años todos

los coches serán autónomos y dentro de 20 las aplicaciones de la comanda vocal

que comportan nuestro teléfonos móviles habrán evolucionado de tal manera que

se convertirán en verdaderos asistentes vocales capaces de responder a la

preguntas más diversas y complejas, lo que modificará nuestra relación al

saber.

El transhumanismo

Hace quince años

que existe la discusión sobre el transhumanismo, un proyecto alrededor del “hombre Aumentado” o

transmutado, por la conjugación de las biotecnologías, las ciencia cognitivas y

la revolución digital. Dos ideas se oponen

en este campo:

·

la

primera alrededor de una humanidad 2.0.

Desde 1990 se pronostica una mutación cercana e incluso se predice la

tele carga de nuestra conciencia en un disco duro.

·

La

segunda la de transformar la materia por las nanotecnologías para recrear la

especie humana por la depuración de su código genético y la modelización de su

actividad cognitiva, alargar considerablemente la existencia corporal,

desarrollar máquinas pensadoras e incluso tal vez eliminar la muerte y fusionar

la inteligencia humana con la de las máquinas.

Claramente, el

transhumanismo [5]mezcla

ciencias y fantasmas, política y ficción, ética y técnica, humano y futuro.

Sería, preciso analizar y clarificar la aplicación y el desarrollo en este

campo a través de grupos de sabios y de expertos interdisciplinarios en cada

uno de los países del planeta. No obstante, además de ser difícil y largo el

proceso, los avances de la tecnología irán más rápidos que la reflexión sobre

ellas.

Conclusión e interpelación

La nueva frontera de la inteligencia artificial

Vicarius, una

empresa estrella de California especialista en el aprendizaje profundo que se

inspira en el cerebro humano para desarrollar alegorismos desea ir más lejos

con sistemas capaces de prever como una información se comportara en diversos entornos y afirman

que han creado un sistemas capaz de leer esas pequeñas imágenes que los

internautas deben identificar[6]

para suscribirse a un servicio y que están concebidas para que los programas no

los descifren. Desde que lo presentó, la

empresa ha obtenido 72 millones de dólares de las estrellas de la Silicom

Valley. ¿Llegaran los ordenadores a descubrir la imaginación y la conciencia?

Ciencia, conocimiento y sabiduría (sophia)

La ciencia

tiene que ofrecernos un sistema que descifre la realidad. La ciencia es una

creación del hombre para relacionar armonías del pensamiento con la de la

realidad: la ciencia busca explicar la realidad mediante leyes, las cuales

posibilitan además predicciones y aplicaciones. El conocimiento científico es

un conocimiento objetivo que se estructura en sistemas verificables, obtenidos

metódicamente y comunicados en un lenguaje construido con reglas precisas. El

método científico cuenta con cuatro procedimientos: observación,

experimentación, hipótesis y teoría.

La sabiduría es un carácter que se desarrolla con la aplicación de la inteligencia en

la experiencia propia, obteniendo conclusiones que nos dan un mayor

entendimiento, que a su vez nos capacitan para reflexionar, sacando

conclusiones que nos dan discernimiento.

La sabiduría y la ética se interrelacionan dando como resultado un individuo que actúa

con buen juicio. La sabiduría como forma especialmente bien

desarrollada tiene sentido común y

se constituye de menor a mayor complejidad, por dato, información y

conocimiento.

En la Sabiduría se destaca el buen juicio

basado en conocimiento y entendimiento, la aptitud de valerse del conocimiento

con éxito, y el entendimiento para resolver problemas, evitar o impedir

peligros, alcanzar metas, o aconsejar.

La sabiduría implica amplitud de conocimiento y profundidad de entendimiento, que son

los que aportan la sensatez y claridad de juicio. El hombre sabio adquiere

conocimiento, merced a la experiencia.

Preguntas:

·

¿Los

conocimientos sin un uso y establecimiento de las buenas prácticas que requiere

la supervivencia son esquivados en este campo hoy en día?

·

¿La

cultura científica contemporánea limita la importancia de la sabiduría y la

intuición?

Las tendencias de

los humanos a tener emociones hacia los objetos e incluso expresar

sentimientos, serán aumentadas frente a las maquinas capaces de responder a

nuestras reacciones.

¿Cómo reaccionarán

éstas máquinas aprendiendo, serán a nuestra imagen y semejanza, quién estará al

servicio de quién si las maquinas piensan y aprenden de los hombres la libertad

de acción y de decisión?...

Tantas y tantas

cuestiones de interés abiertas a las que debemos responder rápidamente antes de

que la realidad se nos escape.

Bibliografia

Antonio Orbe,

Cerebro y Ordenador, Tagus, 2013

Dominique Nora, « Lettres à me

parents sur le monde de demain », Grasset 2015,

Monique Dagnaud, « Le modèle

californien » Odile Jacob, 2016

Serge Tisseron, « Le jour où mon

robot m’aimera: la empathie artificielle », Albin Michel, 2015

Internet :

[1] Artículo de reflexión e interpelación

Autor: Laura

Garcia Vitoria, directora científica

de la Fundación “Territoires de Demain”:

http://www.territories-of-tomorrow.org

http://www.territories-of-tomorrow.org

[3] http://www.directmatin.fr/hi-tech/2016-03-27/video-sophia-le-robot-humanoide-qui-veut-detruire-lhumanite-725960)

http://naukas.com/2012/03/13/transhumanismo-los-arquitectos-del-futuro/

[4] http://www.telesurtv.net/news/Microsoft-apaga-robot-en-Twitter-por-conducta-nazi-y-racista-20160326-0004.html

[6] captchas

Hablar con Sofia